どうも!あきです。

今回はテクニカルSEOとは?から始まり、今までの記事でテクニカルSEOについて触れてきましたが、まだご紹介していない残り3個を紹介します。

正直、今まで紹介してきた施策とは違い、難易度がかなり上がります。

初心者さんだと何を言っているのか?全く理解できない可能性もあります。

でも、何か問題が起きた時に、そう言えばこんな方法があったな!と頭の片隅に入れといて欲しいと思い今回の記事を作成しました。

この記事では3個紹介しますが、合計で11個の施策を今までで説明しています。

他の施策についても関連記事としてご紹介しているので、そちらも合わせて読むことでテクニカルSEOの理解が深まります。

それでは見ていきましょう。

テクニカルSEOとは

テクニカルSEO(技術的なSEO)とは、検索エンジンがWebページを正しくクロール、インデックス、レンダリングできるようにWebサイトの技術的要素を最適化するSEO施策のことです。

もし、クロールやインデックスの概念が理解できない場合は、以下の記事でかなり分かりやすく解説しているので、そちらから読むことをオススメします。

具体的には、GooglebotなどのクローラーにWebページを見つけてもらい、Webページの情報を取得してもらう施策をクローラー向けの施策と言います。

ユーザーが探している情報と最も関連性の高い情報を提供する施策をインデックス向けの施策と呼びます。

・クローラー向けの施策:GogolebotなどのクローラーにWebページのURLを発見させ、コンテンツ内容を取得させるための施策です。

例えば、ドメインを取得したばかりの新しいサイトはクロールされづらいので、XMLサイトマップを設置して送信したりします。他にもWebページにタグ付けしたり、関連するWebページから該当ページへ内部リンクを貼ってリンク階層を浅くするといった対策もあります。

・インデックス向けの施策:ユーザーが探している情報と最も関連性の高い情報(Webページ)を提供するための施策です。

例えば、URLを正規化したり、重複コンテンツをなくすなどの対策が挙げられます。

マーケティング専門書GOENの中のSEOマスター講座ではこれら全てのことを順番に解説しています。

テクニカルSEOのメリットとデメリット

・クローラビリティが向上する:サイトの階層構造をシンプルにしたり、XMLサイトマップを活用することで、Googlebotなどのクローラーがサイト内のWebページを見つけやすくなり、コンテンツ内容を認識しやすくなります。

•ユーザビリティが向上する:レスポンシブデザインの実装でスマホ対応することで、モバイル端末でWebサイトが見やすく使いやすくなります。

・作業を定型化しやすい:GoogleがテクニカルSEOの手法を公開しており、業務範囲は定型化しやすいです。何をすればクロール・インデックスされやすくなるかが明確であるため、誰にでも取り組みやすいでしょう。

・効果がわかりやすい:Webサイトの内部構造を整えれば、コンテンツSEOの効果も最大化できます。Googleアルゴリズムの変更の影響を受けにくく、中長期的な集客が見込めます。

・Googleからの評価が上がり、上位表示されるようになるため、テクニカルSEOを実施する前よりも多くのアクセス数が期待できます。

あき

あき他のページでも言っていますが、テクニカルSEOは自社で完結型で対応できることなので、やらない選択肢はありません。今の時代やって当たり前となっています。

・難易度の高い対策がある:専門知識が必要となる対策があり、一般知識では対応し難い場合があります。HTML、サーバーの調整、専用ファイルの設定などが必要になることがあります。

•効果が出るまでに時間がかかる:SEOは成果が出るまでに時間がかかります。施策を行ったからといって、すぐに検索順位に反映されるわけではありません。

・サーバーやCMSによっては、テクニカルSEOが実施できないことがあります。

・コンテンツの質が低いとテクニカルSEOの効果を得にくいです。

テクニカルSEOの基本3項目を追加で覚えて

以前、以下の記事でテクニカルSEOについて触れました。

この記事で触れたテクニカルSEOの内容は以下です。

・サイト構造の最適化←超重要

・モバイルフレンドリー対応

・ページ表示速度の改善

・SSL化

・サイトマップ送信

そして以下の記事でもテクニカルSEOについての施策をお伝えしました。

この記事で触れたテクニカルSEOの内容は以下です。

・URLの正規化

・内部リンク←超重要

・パンくずリスト

合計で8個の施策を今まででお伝えしましたが、今回はこれらに加えて更に3つお伝えします。

正直、テクニカルSEOに関してはもうほとんど出尽くしたのではないかと思います。

もう一度言いますが、上記で紹介した2つの記事と今回の記事を読むことで、テクニカルSEOに関してはほぼ網羅できたと言っても過言ではないでしょう。

では、残り3つを見ていきましょう。

インデックス制御とnoindexタグの活用

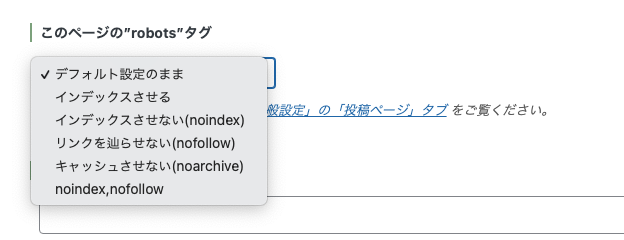

Googleにページをインデックスするかしないか?こちらで選ぶことができます。

noindexタグとは、特定のURLを検索結果に表示させたくない場合に使用するタグです。

検索エンジンのクローラーに対し、「インデックス登録をしないで」と伝える役割を果たします。

例えば、このマーケティング専門書GOENの公式Lineを追加された方には、売り上げUPに役立つ補足資料をまとめた特典一覧ページのリンクをLINEでお送りしています。

このページはLINEを追加した方限定で公開しているURLなので、Google検索では引っ掛かって欲しくない時にnoindexタグを活用します。

あき

あき簡単な話、ネットからの検索で流入して欲しくないページは全てnoindexをしておけばいいのです。

他の場合でnoindexを使うケースは以下です。

・重複コンテンツ:異なるURLで内容が同じ、または非常によく似ているコンテンツのどちらかをインデックスさせない時。

・インデックスさせる必要がないコンテンツ:例えば、サンクスページ、リスティング広告のランディングページ、ダウンロード用のPDFなど。

・インデックスさせたくないコンテンツ:テストページ、管理画面など、特定の人物以外に見せたくないページがある時。

では、このnoindexをすることで一体どんなSEO効果が得られるのかについて見ていきましょう。

・Webサイト全体のSEO評価を高める:noindexタグを適切に設定することで、低品質なコンテンツがインデックスされるのを防ぎ、サイト全体の評価を向上させることができます。

・低品質なコンテンツのインデックスを制御する:品質の低いページをnoindexで除外することで、低品質によるマイナス評価のリスクを軽減します。

・クローラーに対して評価対象ページを的確に伝えられる:評価してほしいページのみがインデックス対象として残るため、Googleからの本来得られる正当な評価を期待できます。

・重複コンテンツの評価分散を防ぐ:サイト内に重複コンテンツが存在する場合、noindexタグを使用することで、検索エンジンが評価を分散させるのを防ぎ、SEO効果を高めることができます。

・クロールの効率化:noindexタグを使用することで、クローラーがWebサイトを巡回する際に、不必要なページをクロールすることを避けられます。これにより、クローラーはより重要なページに集中してクロールできるようになり、Webサイト全体のクロール効率が向上します。

・ペナルティリスクの軽減:コピーコンテンツなど、低品質なコンテンツは、Googleからペナルティを受ける可能性があります。noindexタグを設定することで、これらのコンテンツがインデックスされるのを防ぎ、ペナルティリスクを軽減することができます。

たったの3クリックでインデックスさせるか?させないか?を設定できてこれだけの恩恵を受けれるので必ず設定しましょう。

基本的はインデックスさせるで、必要な時だけインデックスさせないようにしましょう。

サイトの重複コンテンツ対策(canonicalタグの活用)

サイト内の重複コンテンツ対策は、テクニカルSEOにおいて重要な施策です。

重複コンテンツは検索エンジンの評価を下げ、検索順位の低下やペナルティにつながる可能性があるため、適切な対策を講じる必要があります。

まず、重複コンテンツの定義をご説明します。

・同一または類似コンテンツが異なるURLで存在すること

・コンテンツの6割程度が同じ内容である場合も、重複コンテンツと判断される可能性があります。

では、この重複コンテンツがあることで、どんな問題を引き起こすのか?

・検索エンジンがどのURLをインデックスすべきか判断できず、重要なコンテンツがインデックスされない可能性がある。

・クローラーの効率を低下させ、サイト全体の評価を下げる可能性。

・ユーザーに不快感を与え、利便性を損なう可能性がある。

この重複コンテンツ対策としては以下があります。

・noindexタグの使用←説明済み

・canonicalタグの使用

・301リダイレクトの設定←説明済み

・コンテンツの改善・修正←説明済み

・URLの正規化←説明済み

ここではcanonicalタグについて詳しく解説していきます。

canonical(カノニカル)タグの基本的な役割

canonicalタグとは、重複または類似したコンテンツが存在する場合に、検索エンジンに対して評価してほしいURL(正規URL)を伝えるためのHTMLタグのことです。

このcanonicalタグを使って重複コンテンツを避ける場面としては、PCサイトとスマホサイトで異なるURLを利用しているケース。

この場合はcanonicalタグを設定しないと重複コンテンツだと捉えられる可能性があります。

特に難しいのがECサイトです。

ECサイトでは多種多様な商品を扱う中で、サイズや色違いなど、規格が同じ内容で複数のページを作成することがあります。

そんな時もcanonicalタグを使ってURLを正規化することで、検索エンジンからのペナルティを回避することができます。

他にもABテストを実施するとき(LPページ)などの類似コンテンツを利用する場合もcanonicalタグを使ってペナルティーを回避しましょう。

canonicalタグの書き方と設定方法

1、canonicalタグは、HTMLファイルの<head>タグ内にマークアップします。

2、マークアップするページは、基本的にインデックス対象とする全ページに記述します。

3、<head>内に<link rel=”canonical” href=”正規ページのURL”>と記述します。

4、hrefの属性値で記述するページURLは、相対パスではなく絶対パスで記述しましょう。

※HTMLが分からなくてワードプレスを使用している方はプラグインで簡単に設定できます。

canonicalタグを設定できるプラグインはたくさんありますが、私が使っているのは「All in One SEO Pack」のプラグインです。かなり有名プラグインですね

プラグインをインストールして、一般設定から「カノニカルURL」にチェックを入れ、更新して終わりです。

設定が終わったら、サーチコンソールにログイン後、URL検査をクリックし、canonicalタグを設定して公開したページURLを入力します。

情報取得の画面が遷移後、「公開URLをテスト」をクリックしましょう。

そこに表示される「ユーザーが指定した正規URL」がcanonicalタグのahref属性値に記述したページURLと一致してれば、ちゃんと設定されてることになります。

この重複コンテンツはURL正規化と被る部分もあるので、もし今回で理解できない場合は以下の記事のURL正規化を見てください。

日本語URLはOKなのか?どんなURLを付けるべきなのか?などなどURLに特化した内容を詳しくお伝えしています。

また、説明済みと書かれている内容も以下の記事で確認できます。

robots.txtを設定する

robots.txt の設定について説明します。

robots.txtの役割

robots.txtとは、検索エンジンのクローラーに対し、サイト内でアクセス(クロール)して良いURLとそうでないURLを伝えるためのテキストファイルのことです。

robots.txtはサイトのルートディレクトリに配置します。

例えば、サイトURLがhttps://goen.ne.jpの場合、https://goen.ne.jp/robots.txtに配置されます。

robots.txtは、クローラーに対し、ページのインデックスを禁止するものではありません。

もし、完全にインデックスを禁止する場合はnoindexを使用しましょう。

robots.txtを設定するメリット

・クローラビリティの改善:robots.txtを適切に設定することで、クローラーが効率良くサイト内を巡回できるようになり、SEO効果を高めることができます。

・サイト全体のクロール速度を上げる。

・サーバー負荷の軽減:不要なクロールを減らすことで、サーバーへの負荷を軽減できます。

robots.txtを設定すべきケース

・特定のユーザーに限定して見せる情報

・ログインページ

・サイトの仕様上大量のURLが生成されてしまうページ

・動画、画像、PDFなどのファイル

・会員限定ページや複雑な検索条件があるページ

robots.txtの設定方法

・robots.txtファイルを作成し、サイトのルートディレクトリに設置します。

・記述例

→すべてのクローラーに対してすべてのURLへの巡回を拒否する場合:Disallow: /。

→特定のディレクトリ以下のURLを拒否し、それ以外を許可する場合:Disallow: /○○○/。

→すべてのクローラーに対してPDFファイルのクロールを許可しないように制御する場合: User-Agent:* Disallow: /example/sample.pdf

WordPressの場合、管理画面のディレクトリはデフォルトでブロックされています。

作成したrobots.txtファイルは、Google Search Consoleに登録します。

robots.txt設定時の注意点

・robots.txtはnoindexと併用できません。先にインデックスされたものに対してrobots.txtでクローラーを制御し、後からnoindexタグを入れた場合は、インデックスされたままの状態になります。この場合はnoindexでインデックスされなくなってからrobots.txtを使用するなど、検索結果に与える影響を考えて対応する必要があります。

・robots.txtはあくまで指示であり、すべての検索エンジンが従うとは限りません。

・クロールを拒否したいページにnoindexタグを設定している場合、robots.txtでそのページのクロールを拒否してしまうと、クローラーがnoindexタグを認識できなくなるため、robots.txtでのクロール拒否は避ける必要があります。

まとめ

今回の内容は少し難しかったかもしれません。

正直、今回の内容を理解できなくても重複コンテンツを避ける方法はあります。

サイト構造などをしっかりと構築すればそんなに大きなペナルティーが生まれることはありません。

ただし、ECサイトなどの同じようなページを複数作る系のサイトは今回の内容をしっかりと理解しておきましょう。

Googleサーチコンソールを見れば今自分のサイトがペナルティーを受けているのか?すぐに確認できるので、ペナルティーが起きてから対処しても問題ありません。

今回の内容を先読みしておくことで、何か問題が起きた時の対処をスムーズに行うことができるでしょう。

コメント